Data Cloud-företaget Snowflake presenterar idag Snowflake Arctic, en toppmodern stor språkmodell (LLM) som är utformad för att vara den mest transparenta företagsklassade LLM:en på marknaden.

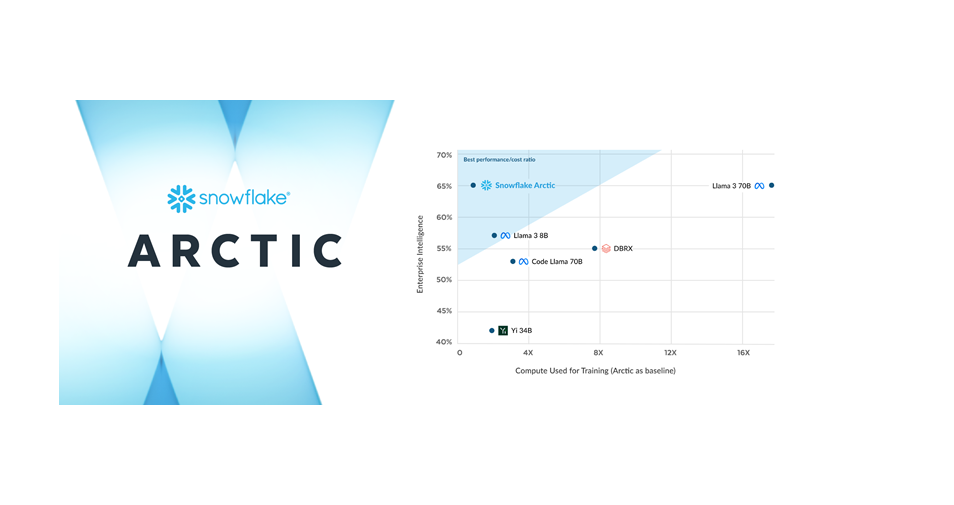

Genom den unika MoE-arkitekturen (Mixture-of-Experts) ger Arctic förstklassiga resultat med oöverträffad effektivitet.

LLM:en är optimerad för komplexa arbetslaster och toppar flera bransch-KPI:er för bland annat generering av SQL-kod och instruktionsföljning. Dessutom sätter Snowflake en ny standard för transparens inom AI-teknik genom att släppa detaljer kring forskningen som legat till grund för hur modellen har tränats, tillsammans med en Apache 2.0-licens för att göra modellen lättillgänglig.

– Detta är ett banbrytande ögonblick för Snowflake och våra AI-forskare som arbetar i AI:s absoluta framkant, säger Sridhar Ramaswamy, VD på Snowflake. Genom att leverera branschledande intelligens och effektivitet på ett helt öppet och tillgängligt sätt, flyttar vi fram gränserna för vad AI med öppen källkod kan göra. Vår forskning med Arctic kommer att avsevärt förbättra vår förmåga att leverera tillförlitlig och effektiv AI till våra kunder.

Bryter ny mark för tillgänglighet och samarbete

Enligt en färsk rapport från Forrester uppgav cirka 46 procent av AI-beslutsfattarna på globala företag att de använder befintliga LLM-modeller med öppen källkod, för att införa generativ AI som en del av sin organisations AI-strategi. Med Snowflake som datagrund för mer än 9 400 företag och organisationer över hela världen, ger det alla användare möjlighet att utnyttja sina data med branschledande öppna LLM-modeller. Detta samtidigt som användarna får flexibilitet och valfrihet när det gäller vilka modeller de vill arbeta med.

Enligt en färsk rapport från Forrester uppgav cirka 46 procent av AI-beslutsfattarna på globala företag att de använder befintliga LLM-modeller med öppen källkod, för att införa generativ AI som en del av sin organisations AI-strategi. Med Snowflake som datagrund för mer än 9 400 företag och organisationer över hela världen, ger det alla användare möjlighet att utnyttja sina data med branschledande öppna LLM-modeller. Detta samtidigt som användarna får flexibilitet och valfrihet när det gäller vilka modeller de vill arbeta med.

Genom Arctic levererar Snowflake en kraftfull och helt öppen modell med en Apache 2.0-licens som tillåter obegränsad användning. Dessutom erbjuds användarna kodmallar och flexibla utbildningar för att snabbt kunna komma igång med, och anpassa Arctic till sitt företags ramverk. Dessa inkluderar NVIDIA NIM med NVIDIA TensorRT-LLM, vLLM och Hugging Face. Arctic finns tillgänglig för användning i Snowflake Cortex, som erbjuder maskininlärning och AI-lösningar i Data Cloud tillsammans med andra modellkataloger som Hugging Face, Lamini, Microsoft Azure, NVIDIA:s API-katalog, Together, med flera.

Accelererar AI-innovationen för alla användare

Snowflake fortsätter att förse företag med den datagrund och de avancerade AI-byggstenar som de behöver för att skapa kraftfulla AI- och ML-appar på sina företagsdata. När Arctic används i Snowflake Cortex kan användare snabbare, och i stor skala, utveckla AI-appar i produktionsklass inom Data Clouds säkerhets- och styrningsperimeter.

Samtidigt prioriterar Snowflake att ge sina kunder tillgång till de senaste och mest kraftfulla LLM-modellerna i Data Cloud, till exempel genom de senaste tilläggen av Reka och Mistral AI:s modeller. Dessutom presenterades nyligen ett utökat samarbete mellan Snowflake och NVIDIA för att förbättra AI-innovationen. Genom att sammanföra NVIDIA:s accelererade plattform med Snowflakes Data Cloud erbjuds en säker och enastående kombination av infrastruktur och beräkningskapacitet, för att accelerera AI-produktiviteten.